在您网站上测试人工智能 60秒内

看看我们的人工智能如何即时分析您的网站并创建个性化聊天机器人 - 无需注册。只需输入您的网址,即可观看其工作方式!

人工智能与数据隐私简介

数据隐私是指保护个人信息免受未经授权的访问、滥用或泄露。人工智能系统通常需要大量数据集才能有效运行,从而导致数据泄露、身份盗窃和算法偏差等潜在风险。随着人工智能的不断发展,平衡创新与道德和法律考虑至关重要,以确保用户数据的安全。

人工智能时代的隐私挑战

海量数据收集

许多人工智能应用,如推荐系统、面部识别技术和语音助手,都需要大量数据来提高其准确性和性能。这导致不断从用户那里收集数据,而这些收集往往是在用户不知情或未同意的情况下进行的。例如,社交媒体平台会跟踪用户互动以改进其算法,但这种做法可能会模糊个性化体验和侵入性监视之间的界限。

缺乏透明度

人工智能最大的担忧之一是其“黑匣子”性质。许多人工智能驱动的决策都难以解释,这使得用户很难理解他们的数据是如何被使用的。如果人工智能模型根据其分析拒绝向某人提供贷款或工作机会,受影响的个人可能无法理解或质疑该决定。这种缺乏透明度可能会破坏人们对人工智能系统的信任并引发道德问题。

偏见和歧视

人工智能系统使用历史数据进行训练,而历史数据可能包含固有偏见。如果不加以谨慎管理,人工智能模型可能会延续甚至加剧歧视。例如,有偏见的面部识别系统被发现会以更高的概率错误识别某些人口群体中的个人。这不仅引发了道德问题,也给依赖人工智能决策的企业带来了法律风险。

增强监控

人工智能驱动的监控工具(如面部识别和行为跟踪)正变得越来越普遍。虽然这些技术可以增强安全性,但它们也对隐私构成了严重威胁。政府和企业可以使用人工智能在未经个人同意的情况下对其进行监控,这引发了人们对大规模监控和个人数据可能被滥用的担忧。

保护人工智能应用程序中个人数据的最佳实践

数据最小化

组织应仅收集其人工智能应用程序所需的数据。减少存储的个人信息量可最大限度地降低发生违规时数据泄露的风险。

数据屏蔽和假名化

数据屏蔽(用虚构值替换敏感数据)和假名化(从数据集中删除直接标识符)等技术可以增强隐私,同时仍允许人工智能模型有效运行。

知情同意和用户意识

用户应该清楚、易于访问地了解他们的数据是如何收集、使用和存储的。实施选择加入政策而不是自动数据收集可确保更高的透明度和用户控制。

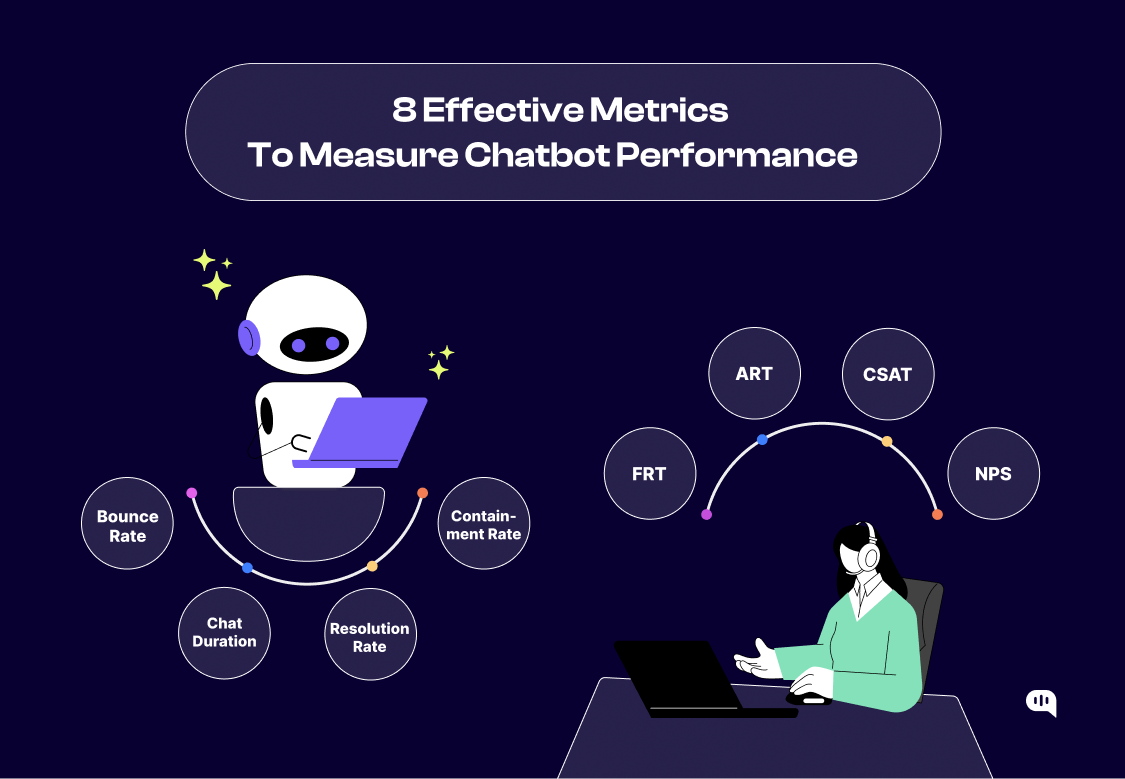

定期安全审计

人工智能系统应接受频繁的安全审计,以识别漏洞和潜在的隐私风险。这包括测试数据泄露、未经授权的访问和偏见检测。

强大的加密协议

加密存储和传输的数据可增加一层额外的安全性,使未经授权的各方更难以访问敏感信息。

监管框架和合规性

《通用数据保护条例》(GDPR)

GDPR 由欧盟执行,对数据收集、存储和用户同意制定了严格的准则。公司必须提供有关数据使用的透明度,并允许个人请求删除数据。

《加州消费者隐私法案》(CCPA)

这项美国法规赋予加州居民对其个人数据的更大控制权,要求公司披露数据收集做法并提供选择退出选项。

针对 AI 的道德准则

包括经合组织和联合国教科文组织在内的多个组织已经出台了道德 AI 准则,强调 AI 开发和部署的透明度、公平性和问责制。

组织在确保数据隐私方面的作用

制定符合道德的 AI 框架:为 AI 开发制定内部指南,优先考虑用户隐私和道德考虑。

对员工进行数据保护培训:教育员工了解数据安全和遵守隐私法规的最佳实践。

实施隐私设计:在 AI 项目的开发阶段整合数据保护措施,而不是事后再考虑。

进行透明沟通:向用户提供有关其数据如何使用的清晰解释,并确保他们能够控制自己的信息。

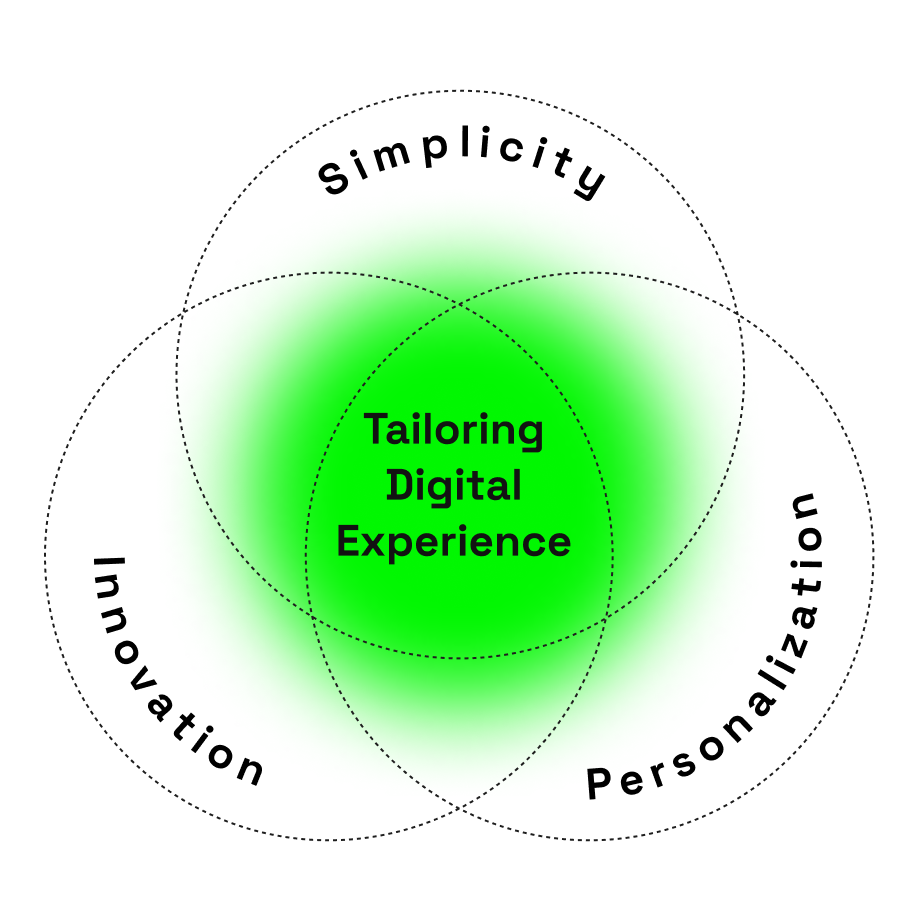

未来展望:平衡创新与隐私

联合学习:一种去中心化的人工智能训练方法,允许模型从数据中学习,而无需将数据转移到中央服务器,从而增强隐私。

人工智能监管和道德人工智能发展:预计世界各国政府将出台更严格的人工智能监管,以防止滥用并确保数据保护。

用户对数据的更大控制:新兴技术可能会让个人对其个人数据拥有更多的控制权,例如使用区块链的自主主权身份系统。