ц╡ЛшпХцВичЪДф╕ЪхКб хИЖщТЯ

хИЫх╗║цВичЪДш┤жцИ╖х╣╢хЬихЗахИЖщТЯхЖЕхРпхКицВичЪДAIшБКхдйцЬ║хЩиф║║уАВхоМхЕихПпхоЪхИ╢я╝МцЧащЬАч╝ЦчаБ - члЛхН│х╝АхзЛхР╕х╝ХцВичЪДховцИ╖я╝Б

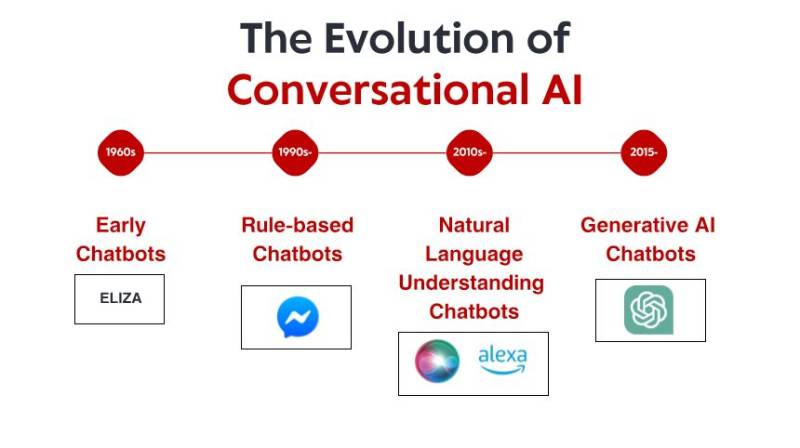

х╝ХшиАя╝ЪNLP хПСх▒ХчЪДц╝ФхПШ

ш┐ЗхО╗ф╕Ах╣┤я╝МNLP цКАцЬпхПЦх╛Чф║ЖцШ╛шСЧш┐ЫцнетАФтАФф╗ОцЫ┤щлШцХИчЪДх╛ош░ГцЦ╣ц│ХхИ░х░ЖцЦЗцЬмф╕ОхЕ╢ф╗ЦцХ░цНоч▒╗хЮЛш┐ЮцОеш╡╖цЭечЪДхдЪцибцАБхКЯшГ╜уАВщЪПчЭАш╢КцЭеш╢КхдЪчЪД NLP х╖еф╜Ьш┤Яш╜╜ш╜мчз╗хИ░ш╛╣ч╝Шшо╛хдЗхТМц╢Иш┤╣ч║зчбмф╗╢я╝Мш┐РшбМцЧ╢цХИчОЗхПШх╛Чш╢КцЭеш╢КщЗНшжБуАВф╕ОцндхРМцЧ╢я╝Мф╕Уф╕ЪщвЖхЯЯшГ╜хКЫф╣Ях╖▓цЙйх▒ХхИ░цЬНхКбф║Оф╗ОхМ╗чЦЧф┐ЭхБехИ░ц│Хх╛ЛцЬНхКбчнЙхРДф╕кшбМф╕Ъя╝МхЕ╢хЗЖчбоцАзш╛╛хИ░ф║ЖхЙНцЙАцЬкцЬЙчЪДц░┤х╣│уАВ

цЧашо║цВицШпцЮДх╗║хп╣шпЭф╗гчРЖуАБхИЖцЮРховцИ╖хПНщжИуАБф╗ОцЦЗцбгф╕нцПРхПЦц┤ЮхпЯя╝Мш┐ШцШпхИЫх╗║хЖЕхо╣чФЯцИРх╖ехЕ╖я╝МщАЙцЛйхРИщАВчЪД NLP х║УщГ╜ф╝ЪцЮБхдзхЬ░х╜▒хУНщб╣чЫочЪДцИРхКЯуАВцЬмцМЗхНЧх░ЖцОвшои 2025 х╣┤цЬАхЕ╖х╜▒хУНхКЫчЪДф╕Гф╕к NLP х║Уя╝МцпФш╛ГхоГф╗мчЪДф╝ШхК┐уАБх▒АщЩРцАзхТМчРЖцГ│чФиф╛Ля╝Мф╗ех╕охКйцВиф╕║ф╕Лф╕Аф╕кх╝АхПСщб╣чЫохБЪхЗ║цШОцЩ║чЪДхЖ│чнЦуАВ

1. Hugging Face Transformers 6.0я╝ЪхоМхЦДчЪДчФЯцАБч│╗ч╗Я

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

цЬАцЦ░чЙИцЬмх╝ХхЕеф║ЖхдЪщб╣щвашжЖцАзхКЯшГ╜я╝Ъ

щлШцХИчЪДх╛ош░ГцбЖцЮ╢я╝ЪхЕицЦ░чЪД EFT цибхЭЧцШ╛шСЧщЩНф╜Оф║Жх░ЖхЯ║чбАцибхЮЛщАВщЕНхИ░чЙ╣хоЪф╗╗хКбцЙАщЬАчЪДшобчоЧщЬАц▒ВуАВф╣ЛхЙНщЬАшжБхдЪхЭЧ GPU ш┐ЫшбМх╛ош░ГчЪДцибхЮЛчО░хЬихПпф╗ехЬиц╢Иш┤╣ч║зчбмф╗╢ф╕Кш┐ЫшбМхоЪхИ╢я╝Мф╕ФцАзшГ╜цНЯхд▒цЮБх░ПуАВ

хдЪцибцАБц╡Бц░┤ч║┐я╝ЪTransformers чО░хЬицПРф╛Ыч▓╛чоАчЪДц╡Бц░┤ч║┐я╝МчФиф║ОцЮДх╗║х░ЖцЦЗцЬмхИЖцЮРф╕ОхЫ╛хГПуАБщЯ│щвСчФЪшЗ│шзЖщвСчРЖшзгцЧач╝Эч╗УхРИчЪДх║ФчФичиЛх║Пя╝МщЭЮх╕╕щАВхРИхИЫх╗║цЫ┤хЕ╖цГЕхвГцДЯчЯешГ╜хКЫчЪДх║ФчФичиЛх║ПуАВ

ф╝Бф╕Ъч║зщГич╜▓х╖ехЕ╖я╝ЪхЕицЦ░чЪДщГич╜▓х╖ехЕ╖хМЕхПпщТИхп╣ф╗ОцЬНхКбхЩищЫЖч╛дхИ░чз╗хКишо╛хдЗчнЙф╕НхРМчбмф╗╢чЫоцаЗш┐ЫшбМшЗкхКиф╝ШхМЦя╝Мф╗ОшАМчоАхМЦф║ЖцибхЮЛф╗ОчаФчй╢хИ░чФЯф║зчЪДш┐Бчз╗ш┐ЗчиЛуАВ

щвЖхЯЯф╕Уф╕ЪхМЦхМЕя╝ЪщТИхп╣хМ╗чЦЧф┐ЭхБеуАБц│Хх╛ЛхТМщЗСшЮНчнЙчЙ╣хоЪшбМф╕ЪщвДхЕИщЕНч╜очЪДшо╛ч╜охТМцибхЮЛя╝Мф╜┐х╝АхПСшАЕшГ╜хдЯф╗ОщвЖхЯЯф╝ШхМЦчЪДхЯ║чбАцибхЮЛхЕецЙЛя╝МшАМщЭЮщАЪчФицибхЮЛуАВ

х╝АхПСшАЕф╕║ф╜ХщТЯчИ▒хоГ

Transformers цМБч╗нхНацНоф╕╗хп╝хЬ░ф╜Ня╝МцШпхЫаф╕║хоГхЬицШУчФицАзхТМх░ЦчлпхКЯшГ╜ф╣ЛщЧ┤хоЮчО░ф║ЖхНУш╢КчЪДх╣│шббуАВшпжх░╜чЪД API ф╜┐цЦ░цЙЛшГ╜хдЯш╜╗цЭ╛хоЮчО░щлШч║з NLP хКЯшГ╜я╝МшАМф╕░хпМчЪДшЗкхоЪф╣ЙщАЙщб╣хИЩшГ╜хдЯц╗бш╢│ч╗ПщкМф╕░хпМчЪДцЬ║хЩихнжф╣ах╖ечиЛх╕ИчЪДщЬАц▒ВуАВ

Hugging Face цЛецЬЙц┤╗ш╖ГчЪДчд╛хМ║я╝Мш┐ЩцДПхС│чЭАх╕╕шзБщЧощвШчЪДшзгхЖ│цЦ╣цбИщАЪх╕╕хПкщЬАхЬишо║хЭЫф╕нцРЬч┤вхН│хПпцЙ╛хИ░я╝Мф╗ОшАМцШ╛шСЧч╝йчЯнф║Жх╝АхПСцЧ╢щЧ┤уАВцибхЮЛф╕нх┐ГчЫохЙНцПРф╛Ыш╢Еш┐З 75,000 ф╕кщвДшонч╗ГцибхЮЛя╝Мх╝АхПСшАЕщАЪх╕╕хПпф╗ецЙ╛хИ░ф╕ОхЕ╢чФиф╛ЛщЬАц▒ВщлШх║жхМ╣щЕНчЪДф╕УчФицибхЮЛя╝МшАМцЧащЬАф╗Охд┤х╝АхзЛуАВ

чРЖцГ│чФиф╛Л

Hugging Face Transformers 6.0 чЪДф╝ШхК┐хЬиф║Оя╝Ъ

щЬАшжБх┐лщАЯшпХщкМф╕НхРМцибхЮЛцЮ╢цЮДчЪДчаФчй╢щб╣чЫо

щЬАшжБцЬАхЕИш┐ЫшпншиАчРЖшзгшГ╜хКЫчЪДчФЯф║зх║ФчФичиЛх║П

х╕МцЬЫхИйчФичд╛хМ║чЯешпЖхТМш╡Дц║РчЪДхЫвщШЯ

щЬАшжБф╕Уф╕ЪщвЖхЯЯчЯешпЖя╝ИхМ╗чЦЧуАБц│Хх╛ЛуАБщЗСшЮНя╝ЙчЪДщб╣чЫо

щЬАшжБхдЪцибцАБхКЯшГ╜чЪДх║ФчФичиЛх║П

ц│ицДПф║Лщб╣

шЩ╜чД╢ Transformers ф╗НчД╢цШпцЬАщАЪчФичЪДщАЙцЛйя╝Мф╜ЖхоГх╣╢щЭЮцА╗цШпцЬАшКВчЬБш╡Дц║РчЪДщГич╜▓цЦ╣цбИуАВф╕Аф║Ых╝АхПСшАЕшбичд║я╝МщАЪчФицЮ╢цЮДф╝Ъх╕жцЭеф╕Аф║Ых╝АщФАя╝МшАМф╕УчФих║УхИЩхПпф╗ещБ┐хЕНш┐Щф║Ых╝АщФАуАВцндхдЦя╝Мх┐лщАЯхПСх▒ХчЪДф╗гчаБх║УцДПхС│чЭАф╕╗шжБчЙИцЬмф╣ЛщЧ┤хБ╢х░Фф╝ЪхЗ║чО░щЗНхдзхПШцЫ┤уАВ

2. SpaCy 4.0я╝ЪчФЯф║зч║зцХИчОЗ

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

SpaCy 4.0 х╕жцЭеф║ЖцШ╛шСЧчЪДхвЮх╝║я╝Ъ

Transformer щЫЖцИРя╝ЪцЫ┤цЦ░хРОчЪД Transformer ц╡Бц░┤ч║┐ч╗Дф╗╢чО░хЬихПпф╗еф╕ОцЬАцЦ░цибхЮЛхОЯчФЯхЕ╝хо╣я╝МхРМцЧ╢ф┐ЭчХЩф║Ж SpaCy щлШцХИчЪДхдДчРЖцЮ╢цЮДуАВ

хвЮх╝║чЪДхдЪхдДчРЖшГ╜хКЫя╝ЪцЦ░чЪДх╣╢шбМхдДчРЖшГ╜хКЫф╕║цЦЗцбгхдДчРЖф╗╗хКбцПРф╛Ыф║Жш┐Сф╣Оч║┐цАзчЪДцЙйх▒ХшГ╜хКЫя╝Мф╜┐ SpaCy шГ╜хдЯцЙ╣щЗПхдДчРЖц╡╖щЗПцЦЗцЬмщЫЖхРИуАВ

цЙйх▒ХчЪДч╗УцЮДхМЦщвДц╡Ля╝ЪщЩдф║ЖхС╜хРНхоЮф╜УшпЖхИлхТМф╛ЭхнШхЕ│ч│╗шзгцЮРф╣ЛхдЦя╝МSpaCy чО░хЬиш┐ШщАЪш┐ЗцЫ┤чБ╡ц┤╗чЪДц│ищЗКхТМшонч╗ГцбЖцЮ╢я╝МхвЮх╝║ф║Жхп╣шЗкхоЪф╣Йч╗УцЮДхМЦщвДц╡Лф╗╗хКбчЪДцФпцМБуАВ

цЫ┤ч▓╛чоАчЪДш┐РшбМцЧ╢шжБц▒Вя╝Ъх░╜чобхКЯшГ╜хвЮх╝║я╝Мца╕х┐ГхдДчРЖц╡Бц░┤ч║┐чО░хЬихПпф╗ецШ╛шСЧхЗПх░СхЖЕхнШхНачФия╝Мш┐Щхп╣ф║ОхЬиш╡Дц║РхПЧщЩРчЪДчОпхвГф╕нщГич╜▓шЗ│хЕ│щЗНшжБуАВ

цФ╣ш┐ЫчЪДшзДхИЩх╝ХцУОя╝Ъцибх╝ПхМ╣щЕНч│╗ч╗Ях╖▓хЕищЭвщЭйцЦ░я╝МцПРф╛ЫцЫ┤х╝║хдзчЪДшбиш╛╛х╝Пя╝МхРМцЧ╢х░ЖхМ╣щЕНщАЯх║жцПРхНЗщлШш╛╛ 300%уАВ

х╝АхПСшАЕщАЙцЛйхоГчЪДхОЯхЫа

SpaCy ф╗НчД╢цШпчФЯф║зч│╗ч╗ЯчЪДщжЦщАЙя╝МхЫаф╕║хоГцПРф╛Ыф║Жх╖еф╕Ъч║зцАзшГ╜хТМх╝АхПСшАЕхПЛхе╜чЪД APIуАВч▓╛х┐Гшо╛шобчЪДщЭвхРСхп╣ш▒бцЮ╢цЮДф╜┐хЕ╢цШУф║ОщЫЖцИРхИ░цЫ┤хдзхЮЛчЪДх║ФчФичиЛх║Пф╕ня╝МхРМцЧ╢ф┐ЭцМБчи│хоЪчЪДцАзшГ╜уАВ

хЕицЦ░чЪДтАЬSpaCy щб╣чЫотАЭцбЖцЮ╢ш┐ШчоАхМЦф║ЖчлпхИ░члп NLP ц╡Бц░┤ч║┐чЪДцЙУхМЕхТМщГич╜▓я╝Мф╜┐хЫвщШЯшГ╜хдЯцаЗхЗЖхМЦф╗ОхоЮщкМхИ░чФЯф║зчЪДх╝АхПСх╖еф╜Ьц╡БчиЛуАВ

чРЖцГ│чФиф╛Л

SpaCy 4.0 щЭЮх╕╕щАВхРИя╝Ъ

щлШхРЮхРРщЗПцЦЗцЬмхдДчРЖч│╗ч╗Я

хПпщЭацАзхТМхПпщвДц╡ЛцАзшЗ│хЕ│щЗНшжБчЪДчФЯф║зчОпхвГ

щЬАшжБх╖еф╕Ъч║зхС╜хРНхоЮф╜УшпЖхИлхТМхЕ│ч│╗цПРхПЦчЪДх║ФчФи

щГич╜▓хПЧщЩРя╝ИхЖЕхнШуАБхдДчРЖшГ╜хКЫя╝ЙчЪДщб╣чЫо

щЬАшжБхРМцЧ╢хЕ╖хдЗч╗ПхЕ╕шЗкчД╢шпншиАхдДчРЖшГ╜хКЫхТМчО░ф╗гчеЮч╗Пч╜Сч╗ЬцЦ╣ц│ХчЪДхЫвщШЯ

ц│ицДПф║Лщб╣

шЩ╜чД╢ SpaCy хЬицХ┤хРИ Transformer цибхЮЛцЦ╣щЭвхПЦх╛Чф║ЖщХ┐ш╢│чЪДш┐Ыцнея╝Мф╜ЖхоГф╗НчД╢цЧац│ХхГП Hugging Face щВгца╖цПРф╛Ых╣┐ц│ЫчЪДхЙНц▓┐чаФчй╢хоЮчО░уАВцндхдЦя╝Мф╕Аф║Ых╝АхПСшАЕшодф╕║хЕ╢хЫ║цЙзх╖▒шзБчЪДцЮ╢цЮДхп╣ф║ОщлШх║жхоЪхИ╢чЪДчаФчй╢х║ФчФишАМшиАф╕НхдЯчБ╡ц┤╗уАВ

3. Cohere SDKя╝ЪAPI-First шпншиАцЩ║шГ╜

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

Cohere х╣│хП░цПРф╛ЫхдЪщб╣х╝Хф║║ц│ичЫочЪДхКЯшГ╜я╝Ъ

Command хТМ Command-R цибхЮЛя╝Ъш┐Щф║ЫцибхЮЛцУЕщХ┐щБ╡х╛кчЙ╣хоЪцМЗф╗дх╣╢чРЖшзгч╗Жх╛очЪДшп╖ц▒Вя╝МхЫацндщЭЮх╕╕щАВхРИцЮДх╗║шГ╜хдЯч▓╛чбохУНх║ФчФицИ╖цЯешпвчЪДх╖ехЕ╖уАВ

х╡МхЕецибхЮЛя╝ЪцЬАцЦ░ф╕Аф╗гх╡МхЕецибхЮЛшГ╜хдЯхИЫх╗║цЮБхЕ╢ч▓╛чбочЪДшпнф╣Йшбичд║я╝МхЬицгАч┤вхТМхИЖч▒╗ф╗╗хКбф╕нчЪДшбичО░цШ╛шСЧф╝Шф║Оф╗ех╛АчЪДцЦ╣ц│ХуАВ

ф╝Бф╕ЪхоЪхИ╢я╝Ъхп╣ф║ОцЬЙчЙ╣хоЪщЬАц▒ВчЪДч╗Дч╗Зя╝МCohere чО░хЬицПРф╛ЫхоЪхИ╢щАЙщб╣я╝Мф╜┐хЕ╢ца╕х┐ГцибхЮЛшГ╜хдЯщАВх║ФчЙ╣хоЪщвЖхЯЯя╝МшАМцЧащЬАхдзщЗПчЪДшонч╗ГцХ░цНощЫЖуАВ

хдЪшпншиАцФпцМБя╝Ъх╝║хдзчЪДхКЯшГ╜ц╢╡чЫЦ 100 хдЪчзНшпншиАя╝МцФпцМБхЕичРГх║ФчФичиЛх║Пя╝МцЧащЬАф╕║цпПчзНшпншиАхНХчЛмхИЫх╗║цибхЮЛуАВ

ш┤Яш┤гф╗╗чЪД AI цОзхИ╢я╝ЪхЖЕч╜охоЙхЕиш┐Зц╗дхЩихТМхБПшзБцгАц╡ЛхКЯшГ╜я╝Мх╕охКйх╝АхПСшАЕхИЫх╗║чмжхРИцЧечЫКщЗНшжБчЪДщБУх╛╖цаЗхЗЖчЪДч│╗ч╗ЯуАВ

х╝АхПСшАЕщАЙцЛйхоГчЪДхОЯхЫа

Cohere SDK ф╣ЛцЙАф╗ехПЧхИ░х╣┐ц│ЫхЕ│ц│ия╝Мф╕╗шжБцШпхЫаф╕║хоГцШ╛шСЧщЩНф╜Оф║ЖхоЮчО░хдНцЭВ NLP хКЯшГ╜чЪДщЧицзЫуАВхН│ф╜┐ц▓бцЬЙцЬ║хЩихнжф╣аф╕Уф╕ЪчЯешпЖчЪДх╝АхПСшАЕя╝Мф╣ЯшГ╜чФицЬАх░СчЪДф╗гчаБф╕║х║ФчФичиЛх║Пц╖╗хКащлШч║зшпншиАчРЖшзгхКЯшГ╜я╝МхРМцЧ╢хЬищЬАшжБцЧ╢ф╗НшГ╜хп╣цибхЮЛшбМф╕║ш┐ЫшбМч▓╛ч╗ЖцОзхИ╢уАВ

API ф╝ШхЕИчЪДцЦ╣ц│Хф╣ЯцДПхС│чЭАхЫвщШЯцЧащЬАцЛЕх┐ГхЯ║чбАшо╛цЦ╜чобчРЖцИЦш╖Яф╕КцЬАцЦ░чЪДчаФчй╢ш┐Ых▒ХтАФтАФCohere ф╝ЪхдДчРЖш┐Щф║ЫцЦ╣щЭвя╝Мшойх╝АхПСшАЕф╕Уц│иф║Оф╗Цф╗мчЪДх║ФчФичиЛх║ПщА╗ш╛СуАВ

чРЖцГ│чФиф╛Л

Cohere SDK щЭЮх╕╕щАВхРИя╝Ъ

ц▓бцЬЙф╕УчФицЬ║хЩихнжф╣ахЯ║чбАцЮ╢цЮДчЪДхИЭхИЫхЕмхП╕хТМхЫвщШЯ

щЬАшжБх┐лщАЯцЙйх▒ХшАМцЧащЬАчобчРЖцибхЮЛщГич╜▓чЪДх║ФчФичиЛх║П

щЬАшжБф╝Бф╕Ъч║зхПпщЭацАзхТМцФпцМБчЪДщб╣чЫо

цЬНхКбф║ОхЕичРГх╕ВхЬ║чЪДхдЪшпншиАх║ФчФичиЛх║П

ф╝ШхЕИшАГшЩСш┤Яш┤гф╗╗чЪД AI хоЮш╖╡чЪДчФиф╛Л

ц│ицДПф║Лщб╣

Cohere чЪДф╕╗шжБч╝║чВ╣цШпх╝АхПСшАЕф╛Эш╡Цф║Очммф╕ЙцЦ╣цЬНхКбя╝МшАМф╕НцШпхЬишЗкх╖▒чЪДхЯ║чбАцЮ╢цЮДф╕нш┐РшбМцибхЮЛуАВш┐Щх╕жцЭеф║ЖцХ░цНощЪРчзБуАБцЬНхКбхПпчФицАзхТМщХ┐цЬЯф╗╖ца╝чи│хоЪцАзцЦ╣щЭвчЪДц╜ЬхЬицЛЕх┐зуАВф╕Аф║Ых╝АхПСшАЕш┐ШцМЗхЗ║я╝МхЯ║ф║О API чЪДцЦ╣ц│ХшЩ╜чД╢цЦ╣ф╛┐я╝Мф╜Жф╕ОчЫ┤цОешо┐щЧоцибхЮЛхЖЕщГичЫ╕цпФя╝МцЬЙцЧ╢ф╝ЪщЩРхИ╢чБ╡ц┤╗цАзуАВ

4. PyTorch NLPя╝Иtorchtext 3.0я╝Йя╝ЪчаФчй╢ф║║хСШчЪДщАЙцЛй

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

цЬАцЦ░чЙИцЬмх╕жцЭеф║ЖхЗащб╣щЗНхдзхНЗч║зя╝Ъ

хОЯчФЯцФпцМБ Transformer цЮ╢цЮДя╝Ъц│ицДПхКЫцЬ║хИ╢хТМ Transformer цибхЭЧчЪДхНУш╢КхоЮчО░я╝Мф╜┐шЗкхоЪф╣ЙцЮ╢цЮДчЪДхоЮчО░цЫ┤хКаш╜╗цЭ╛уАВ

ф╝ШхМЦчЪДцХ░цНохдДчРЖц╡Бц░┤ч║┐я╝ЪцЦ░чЪДчЯвщЗПхМЦцЦЗцЬмхдДчРЖцУНф╜ЬшГ╜хдЯцЫ┤цЬЙцХИхЬ░хИйчФичО░ф╗г CPU хТМ GPUя╝МцШ╛шСЧхКах┐лщвДхдДчРЖцнещкдуАВ

хвЮх╝║чЪДш┐Бчз╗хнжф╣ацбЖцЮ╢я╝ЪцФ╣ш┐ЫчЪД API ф╜┐щвДшонч╗ГцибхЮЛшГ╜хдЯш╜╗цЭ╛х║ФчФиф║ОцЦ░ф╗╗хКбя╝МхРМцЧ╢ф┐ЭцМБхп╣шонч╗Гш┐ЗчиЛчЪДч▓╛чбоцОзхИ╢уАВ

щЗПхМЦхТМхЙкцЮЭх╖ехЕ╖я╝ЪхЖЕч╜очЪДцибхЮЛхОЛч╝йхКЯшГ╜ф╜┐чаФчй╢ф║║хСШшГ╜хдЯч╝йхЗПцибхЮЛхдзх░Пх╣╢ч╝йчЯнцОичРЖцЧ╢щЧ┤я╝МшАМф╕Нф╝Ъш┐Зх║жщЩНф╜ОцАзшГ╜уАВ

цФ╣ш┐ЫчЪДцЙ╣хдДчРЖя╝ЪцЫ┤цЩ║шГ╜чЪДхПпхПШщХ┐х║жх║ПхИЧцЙ╣хдДчРЖчнЦчХехПпцПРщлШшонч╗ГцЬЯщЧ┤ GPU чЪДхИйчФичОЗуАВ

чаФчй╢ф║║хСШхТМх╝АхПСшАЕщАЙцЛйхоГчЪДхОЯхЫа

PyTorch NLP ф╗НчД╢цШпчаФчй╢хТМф╕Уф╕Ъх║ФчФичЪДщжЦщАЙя╝МхЫаф╕║хоГхЬиф╕НчЙ║чЙ▓хПпчФицАзчЪДцГЕхЖ╡ф╕ЛцПРф╛Ыф║ЖцЬАхдзчЪДчБ╡ц┤╗цАзуАВхС╜ф╗дх╝Пч╝ЦчиЛщгОца╝ф╕ОхдзхдЪцХ░х╝АхПСшАЕчЪДцАЭч╗┤цЦ╣х╝ПчЫ╕чмжя╝Мф╜┐хЕ╢цЫ┤цШУф║Ош░ГшпХцибхЮЛхТМх░ЭшпХцЦ░цЦ╣ц│ХуАВ

ф╕ОцЫ┤х╣┐ц│ЫчЪД PyTorch чФЯцАБч│╗ч╗ЯчЪДцЧач╝ЭщЫЖцИРф╣ЯцДПхС│чЭАщАЪчФиц╖▒х║жхнжф╣ая╝Иф╛ЛхжВф╝ШхМЦцКАцЬпцИЦшонч╗ГцЦ╣ц│Хя╝ЙчЪДш┐ЫцнехПпф╗ечлЛхН│х║ФчФиф║О NLP ф╗╗хКбуАВ

чРЖцГ│чФиф╛Л

PyTorch NLP цЬАщАВхРИя╝Ъ

цОвч┤вцЦ░хЮЛцЮ╢цЮДцИЦшонч╗ГцЦ╣ц│ХчЪДчаФчй╢щб╣чЫо

щЬАшжБхоЪхИ╢цибхЮЛшбМф╕║ф╕ФщлШч║зх║Уф╕нф╕НцПРф╛Ыцндч▒╗шбМф╕║чЪДх║ФчФи

щЬАшжБчРЖшзгцибхЮЛхЖЕщГихОЯчРЖчЪДцХЩшВ▓хЬ║цЩп

щЬАшжБф╕ОшобчоЧцЬ║шзЖшзЙцИЦхЕ╢ф╗ЦцибцАБщЫЖцИРчЪДщб╣чЫо

щЬАшжБцЬАхдзчиЛх║жцОзхИ╢шонч╗Гш┐ЗчиЛчЪДцГЕхЖ╡

ц│ицДПф║Лщб╣

PyTorch NLP чЪДчБ╡ц┤╗цАзцДПхС│чЭАцЫ┤щЩбх│нчЪДхнжф╣ацЫ▓ч║┐хТМцЫ┤хдЪчЪДхоЮчО░ш┤гф╗╗уАВф╕ОщлШч║зх║УчЫ╕цпФя╝Мх╝АхПСф║║хСШщЬАшжБхБЪхЗ║цЫ┤хдЪцЮ╢цЮДхЖ│чнЦх╣╢ф╗Охд┤х╝АхзЛхоЮчО░цЫ┤хдЪч╗Дф╗╢уАВцндхдЦя╝Мф╕Аф║ЫчФЯф║зф╝ШхМЦхКЯшГ╜щЬАшжБщвЭхдЦчЪДх╖еф╜ЬцЙНшГ╜цнгчбохоЮчО░уАВ

ц╡ЛшпХцВичЪДф╕ЪхКб хИЖщТЯ

хИЫх╗║цВичЪДш┤жцИ╖х╣╢хЬихЗахИЖщТЯхЖЕхРпхКицВичЪДAIшБКхдйцЬ║хЩиф║║уАВхоМхЕихПпхоЪхИ╢я╝МцЧащЬАч╝ЦчаБ - члЛхН│х╝АхзЛхР╕х╝ХцВичЪДховцИ╖я╝Б

5. JAX NLPя╝ИFLAX/Praxя╝Йя╝ЪшзДцибцАзшГ╜

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

JAX чЪД NLP чФЯцАБч│╗ч╗ЯхЕ╖цЬЙф╗еф╕ЛхЗахдзчЛмчЙ╣ф╝ШхК┐я╝Ъ

щАПцШО XLA ч╝ЦшпСя╝ЪщТИхп╣ TPUуАБGPU хТМф╕УчФичбмф╗╢чЪДшЗкхКиф╝ШхМЦя╝МцШ╛шСЧцПРхНЗф║Жшонч╗ГхТМцОичРЖщАЯх║жуАВ

хЗ╜цХ░х╝Пч╝ЦчиЛцибхЮЛя╝Ъч║пхЗ╜цХ░х╝ПцЦ╣ц│ХчоАхМЦф║Жш╖ихдЪшо╛хдЗчЪДхИЖх╕Гя╝Мх╣╢цЬЙхКйф║ОщБ┐хЕНч╗Жх╛очЪДшонч╗ГщФЩшппуАВ

щлШч║зх╣╢шбМцАзя╝ЪхЖЕч╜охп╣цибхЮЛуАБцХ░цНохТМц╡Бц░┤ч║┐х╣╢шбМцАзчЪДцФпцМБя╝Мф╜┐хдзшзДцибцибхЮЛшонч╗ГцЫ┤хКаф╛┐цН╖уАВ

чбмф╗╢ф╕УчФиф╝ШхМЦя╝Ъф╕УчФихоЮчО░хЕЕхИЖхИйчФиф║Жф╕НхРМчбмф╗╢ф╛Ых║ФхХЖчЪДцЬАцЦ░хКащАЯхЩихКЯшГ╜уАВ

х╖ох╝ВщЪРчзБщЫЖцИРя╝ЪхЖЕч╜охп╣щЪРчзБшонч╗ГцЦ╣ц│ХчЪДцФпцМБя╝Мц╗бш╢│ф║ЖцЧечЫКхвЮщХ┐чЪДцХ░цНощЪРчзБчЫСчобшжБц▒ВуАВ

хЫвщШЯщАЙцЛйхоГчЪДхОЯхЫа

хдДчРЖш╢ЕхдзхЮЛцибхЮЛцИЦцХ░цНощЫЖчЪДч╗Дч╗ЗщАЙцЛйхЯ║ф║О JAX чЪДшзгхЖ│цЦ╣цбИф╕╗шжБцШпф╕║ф║ЖшО╖х╛ЧцАзшГ╜ф╝ШхК┐уАВхЬихЕ╢ф╗ЦцбЖцЮ╢ф╕КщЬАшжБцХ░хСицЧ╢щЧ┤цЙНшГ╜шонч╗ГчЪДцибхЮЛя╝Мф╜┐чФи JAX щАЪх╕╕хПпф╗ехЬихЗахдйхЖЕхоМцИРя╝Мш┐ЩцДПхС│чЭАф║СшобчоЧш╡Дц║РцИРцЬмчЪДцШ╛шСЧшКВчЬБуАВ

хЗ╜цХ░х╝ПцЦ╣ц│Хш┐Шх╕жцЭеф║ЖхПпщЗНхдНцАзхТМш░ГшпХцЦ╣щЭвчЪДф╝ШхК┐я╝МщЪПчЭАцибхЮЛхдНцЭВх║жчЪДхвЮхКахТМшонч╗ГцИРцЬмчЪДцПРщлШя╝Мш┐Щф╕АчВ╣хПШх╛Чш╢КцЭеш╢КщЗНшжБуАВ

чРЖцГ│чФиф╛Л

JAX NLP щЭЮх╕╕щАВхРИя╝Ъ

шонч╗ГхТМщГич╜▓ш╢ЕхдзхЮЛшпншиАцибхЮЛ

хПпф╗еф╜┐чФиф╕УчФичбмф╗╢я╝ИTPU чнЙя╝ЙчЪДч╗Дч╗З

щЬАшжБцЬАхдзшобчоЧцХИчОЗчЪДщб╣чЫо

хПпщЗНхдНцАзшЗ│хЕ│щЗНшжБчЪДцГЕхЖ╡

щЬАшжБф╕еца╝щЪРчзБф┐ЭщЪЬчЪДх║ФчФичиЛх║П

ц│ицДПф║Лщб╣

JAX чЪДч╝ЦчиЛцибхЮЛшЩ╜чД╢хКЯшГ╜х╝║хдзя╝Мф╜Жф╕ОхЕ╢ф╗ЦцбЖцЮ╢ф╕нцЫ┤х╕╕шзБчЪДщЭвхРСхп╣ш▒бцЦ╣ц│ХхнШхЬицШ╛шСЧх╖ох╝ВуАВш┐ЩхПпшГ╜ф╝ЪхвЮхКахИЭхзЛхнжф╣ацЫ▓ч║┐я╝Мх░дхЕ╢цШпхп╣ф║Оц▓бцЬЙх╝║хдзхЗ╜цХ░х╝Пч╝ЦчиЛшГМцЩпчЪДх╝АхПСф║║хСШшАМшиАуАВцндхдЦя╝МшЩ╜чД╢чФЯцАБч│╗ч╗ЯцнгхЬих┐лщАЯхПСх▒Хя╝Мф╜Жф╕ОцЫ┤цИРчЖЯчЪДцбЖцЮ╢чЫ╕цпФя╝МхЕ╢хПпчлЛхН│ф╜┐чФичЪДч╗Дф╗╢ф╗НчД╢ш╛Гх░СуАВ

6. TensorFlow Text 3.0я╝Ъф╝Бф╕Ъчи│хоЪцАз

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

TensorFlow Text 3.0 цПРф╛Ыф║ЖхдЪщб╣щЗНшжБхвЮх╝║я╝Ъ

ф╕О TF Extended щЫЖцИРя╝Ъф╕О TensorFlow чЪДчФЯф║зч║зцЬ║хЩихнжф╣ац╡Бц░┤ч║┐х╖ехЕ╖цЧач╝Эш┐ЮцОея╝МчоАхМЦф║Жф╗ОхоЮщкМхИ░щГич╜▓чЪДцХ┤ф╕кш┐ЗчиЛуАВ

хвЮх╝║чЪД TFLite цФпцМБя╝ЪTFLite ф╕нцФ╣ш┐ЫчЪДцЦЗцЬмхдДчРЖцУНф╜Ьф╜┐х░Ж NLP цибхЮЛщГич╜▓хИ░чз╗хКихТМш╛╣ч╝Шшо╛хдЗцЫ┤хКахИЗхоЮхПпшбМуАВ

ф╕АшЗ┤чЪДш╖их╣│хП░ф╜УщкМя╝ЪчЫ╕хРМчЪДцибхЮЛхТМхдДчРЖц╡Бц░┤ч║┐хПпхЬиф╗Оф║Счлп TPU хИ░чз╗хКишо╛хдЗчЪДхРДчзНшонч╗ГхТМцОичРЖчОпхвГф╕нхПпщЭахЬ░ш┐РшбМуАВ

цЙйх▒ХчЪДф╝Бф╕ЪщЫЖцИРя╝ЪчФиф║Ох╕╕шзБф╝Бф╕ЪцХ░цНоц║РчЪДхОЯчФЯш┐ЮцОехЩичоАхМЦф║Жх░ЖцЦЗцЬмхдДчРЖщЫЖцИРхИ░чО░цЬЙх╖еф╜Ьц╡БчиЛчЪДш┐ЗчиЛуАВ

хЕищЭвчЪДцЬНхКбщАЙщб╣я╝Ъф╗О TF Serving хИ░ SavedModel хЖНхИ░ TFLiteя╝МщГич╜▓щАЙщб╣хЗаф╣Оц╢╡чЫЦцЙАцЬЙчЫоцаЗчОпхвГуАВ

ф╝Бф╕ЪщАЙцЛйхоГчЪДхОЯхЫа

TensorFlow Text хЬиф╝Бф╕ЪчОпхвГф╕нф╛ЭчД╢хдЗхПЧцмвш┐Оя╝МхЫаф╕║хоГцПРф╛Ыф║Жф╗ОцХ░цНохЗЖхдЗхИ░щГич╜▓чЪДхоМцХ┤шзгхЖ│цЦ╣цбИуАВчи│хоЪчЪД API хТМф╕░хпМчЪДщГич╜▓щАЙщб╣щЩНф╜Оф║Жх░Ж NLP щЫЖцИРхИ░хЕ│щФоф╗╗хКбх║ФчФичиЛх║Пф╕нчЪДщгОщЩйуАВ

ф╕О Google ф║СцЬНхКбчЪДщЫЖцИРф╣Яф╕║х╖▓хЬишпечФЯцАБч│╗ч╗Яф╕нцКХш╡ДчЪДч╗Дч╗ЗцПРф╛Ыф║Жф╕АцЭбчоАхНХчЪДцЙйх▒Хш╖пх╛ДуАВ

чРЖцГ│чФиф╛Л

TensorFlow Text 3.0 чЪДф╝ШхК┐хЬиф║Оя╝Ъ

щЬАшжБчФЯф║зчи│хоЪцАзчЪДф╝Бф╕Ъх║ФчФичиЛх║П

чз╗хКихТМш╛╣ч╝ШщГич╜▓хЬ║цЩп

х╖▓цКХш╡Д TensorFlow чЪДч╗Дч╗З

щЬАшжБхЕищЭвцЬ║хЩихнжф╣ац╡Бц░┤ч║┐чЪДщб╣чЫо

щГич╜▓чБ╡ц┤╗цАзшЗ│хЕ│щЗНшжБчЪДх║ФчФичиЛх║П

ц│ицДПф║Лщб╣

шЩ╜чД╢ TensorFlow Text ф╕НцЦнц╖╗хКацЦ░хКЯшГ╜я╝Мф╜ЖхоГхЬихоЮцЦ╜цЬАцЦ░чаФчй╢ш┐Ых▒ХцЦ╣щЭвцЬЙцЧ╢шР╜хРОф║ОхЕ╢ф╗ЦцбЖцЮ╢уАВцндхдЦя╝Мф╕Аф║Ых╝АхПСшАЕхПСчО░я╝Мф╕О PyTorch чЪДхС╜ф╗дх╝ПцЦ╣ц│ХчЫ╕цпФя╝МчмжхП╖х╝Пч╝ЦчиЛцибхЮЛхЬихоЮщкМцЦ╣щЭвф╕НхдЯчЫ┤шзВуАВ

7. Flair 2.0я╝ЪNLP чЪДчСЮхглхЖЫхИА

ф╕╗шжБхКЯшГ╜хТМцФ╣ш┐Ы

Flair 2.0 х╕жцЭеф║ЖхЗащб╣цШ╛шСЧчЪДцФ╣ш┐Ыя╝Ъ

ц╖╖хРИх╡МхЕецбЖцЮ╢я╝Ъш╜╗цЭ╛ч╗ДхРИф╕НхРМч▒╗хЮЛчЪДх╡МхЕея╝Иф╕Кф╕ЛцЦЗуАБщЭЩцАБуАБхнЧчмжч║зя╝Йя╝Мф╗ехоЮчО░чЙ╣хоЪф╗╗хКбчЪДцЬАф╜│цАзшГ╜уАВ

хНХца╖цЬмхнжф╣ашГ╜хКЫя╝ЪцЦ░чЪДх░Пца╖цЬмхнжф╣ацКАцЬпхЬичЙ╣хоЪф╗╗хКбф╕Кя╝Мф╗ецЬАх░СчЪДцаЗц│ицХ░цНохПЦх╛Чф║Жф╗дф║║цГКшо╢чЪДшЙпхе╜цХИцЮЬуАВ

хвЮх╝║чЪДцЦЗцбгцЩ║шГ╜я╝ЪцФ╣ш┐ЫчЪДцЦЗцбгх╗║цибцЦ╣ц│ХшГ╜хдЯцЫ┤хе╜хЬ░цНХцНЙщХ┐цЦЗцЬмф╕нчЪДщХ┐чиЛф╛Эш╡ЦхЕ│ч│╗уАВ

ч▓╛чоАчЪДх╛ош░Гя╝ЪчоАхМЦф║Жх░ЖщвДшонч╗ГцибхЮЛщАВщЕНхИ░чЙ╣хоЪщвЖхЯЯцИЦф╗╗хКбчЪДх╖еф╜Ьц╡БчиЛуАВ

цЫ┤ш╜╗чЪДш╡Дц║РщЬАц▒Вя╝ЪцЫ┤щлШчЪДцХИчОЗф╜┐ Flair цЫ┤щАВхРИщГич╜▓хЬицАзшГ╜ш╛Гх╝▒чЪДчбмф╗╢ф╕КуАВ

х╝АхПСшАЕщАЙцЛйхоГчЪДхОЯхЫа

Flair хЫахЕ╢хЬихКЯшГ╜х╝║хдзф╕ОчоАц┤БцШУчФиф╣ЛщЧ┤хПЦх╛ЧчЪДхоМч╛Ох╣│шббшАМш╡вх╛Чф║Жф╝ЧхдЪх┐ахоЮцЛеш╢╕уАВшпех║УхЬишо╕хдЪх╕╕шзБчЪД NLP ф╗╗хКбф╕нцПРф╛Ыф║Жш┐Сф╣Ощб╢х░ЦчЪДцАзшГ╜я╝МхРМцЧ╢цЙАщЬАчЪДф╗гчаБщЗПхТМшобчоЧш╡Дц║Рш┐Ьх░Сф║ОхЕ╢ф╗ЦхдзхЮЛцбЖцЮ╢уАВ

чЫ┤шзВчЪД API шо╛шобф╣Яф╜┐щЭЮ NLP ф╕Ухо╢чЪДх╝АхПСшАЕф╣ЯшГ╜ш╜╗цЭ╛ф╕КцЙЛя╝Мф╗ечЫ╕хп╣х╣│ч╝УчЪДхнжф╣ацЫ▓ч║┐х░ЖхдНцЭВчЪДшпншиАчРЖшзгхКЯшГ╜шЮНхЕехИ░ф╗Цф╗мчЪДх║ФчФичиЛх║Пф╕нуАВ

чРЖцГ│чФиф╛Л

Flair 2.0 цЬАщАВхРИя╝Ъ

щЬАшжБхЗ║шЙ▓х║ПхИЧцаЗц│ия╝ИNERуАБPOS цаЗц│ия╝ЙчЪДщб╣чЫо

шобчоЧш╡Дц║РцЬЙщЩРчЪДх║ФчФи

хп╗ц▒Вх┐лщАЯхоЮчО░цаЗхЗЖ NLP ф╗╗хКбчЪДхЫвщШЯ

цаЗц│ишонч╗ГцХ░цНощЗПцЮБх░СчЪДхЬ║цЩп

ф╕Уф╕ЪчЪДцЦЗцЬмхИЖч▒╗х║ФчФи

ц│ицДПф║Лщб╣

шЩ╜чД╢ Flair ф╕НцЦнцЙйх▒ХхЕ╢хКЯшГ╜я╝Мф╜ЖхоГцПРф╛ЫчЪДцибхЮЛхТМцКАцЬпф╕НхжВ Hugging Face Transformers чнЙхдзхЮЛцбЖцЮ╢щВгца╖х╣┐ц│ЫуАВцндхдЦя╝Мф╕Аф║Ых╝АхПСф║║хСШцМЗхЗ║я╝МхЕ╢цЦЗцбгшЩ╜чД╢цЬЙцЙАцФ╣ш┐Ыя╝Мф╜Жф╗НчД╢ч╝║ф╣ПцЫ┤цИРчЖЯчЪДх║Уф╕нцЙАхМЕхРлчЪДхЕищЭвчд║ф╛ЛуАВ

ч╗Ушо║я╝ЪщАЙцЛйщАВхРИцВищЬАц▒ВчЪД NLP х║У

Hugging Face Transformers 6.0 цПРф╛ЫцЬАхЕищЭвчЪДчФЯцАБч│╗ч╗ЯхТМцибхЮЛщАЙцЛй

SpaCy 4.0 цПРф╛Ых╖еф╕Ъч║зцАзшГ╜хТМчФЯф║зч║зхПпщЭацАз

Cohere SDK цПРф╛Ы API ф╝ШхЕИчЪДф╛┐цН╖цАзя╝Мх╣╢цМБч╗нцЫ┤цЦ░цибхЮЛ

PyTorch NLP ф╕║чаФчй╢ф║║хСШцПРф╛ЫцЬАхдзчЪДчБ╡ц┤╗цАзхТМцОзхИ╢хКЫ

JAX NLP ф╕║хдзшзДцибх║ФчФичиЛх║ПцПРф╛ЫцЧаф╕Оф╝жцпФчЪДцАзшГ╜

TensorFlow Text 3.0 цПРф╛Ыф╝Бф╕Ъч║зчи│хоЪцАзхТМщГич╜▓щАЙщб╣

Flair 2.0 х░Жх╝║хдзчЪДхКЯшГ╜щЫЖцИРхЬиф╕Аф╕кш╜╗щЗПч║зш╜пф╗╢хМЕф╕н

цнгчбочЪДщАЙцЛйхПЦхЖ│ф║ОцВичЪДхЕ╖ф╜УщЬАц▒Вя╝Ъ

хп╣ф║Ох┐лщАЯхОЯхЮЛшо╛шобхТМшо┐щЧоцЬАхЕИш┐ЫчЪДцибхЮЛя╝МHugging Face Transformers ф╗НчД╢цШпцВичЪДщжЦщАЙуАВхжВцЮЬчФЯф║зч║зхПпщЭацАзхТМцХИчОЗцШпцВичЪДф╕╗шжБхЕ│ц│ичВ╣я╝МSpaCy х░ЖцМБч╗нф┐ЭцМБхНУш╢КшбичО░уАВх╜Ух╝АхПСщАЯх║жхТМхоЮцЦ╜ф╛┐цН╖цАзшЗ│хЕ│щЗНшжБцЧ╢я╝МCohere чЪД API ф╝ШхЕИцЦ╣ц│Хх░Жх╕жцЭецШ╛шСЧчЪДф╝ШхК┐уАВ

щЬАшжБцЮБщлШчБ╡ц┤╗цАзчЪДчаФчй╢ф║║хСШф╗Нх░ЖхА╛хРСф║О PyTorch NLPя╝МшАМшонч╗ГхдзшзДцибцибхЮЛчЪДч╗Дч╗Зх░ЖхПЧчЫКф║О JAX чЪДцАзшГ╜ф╝ШхМЦуАВщЗНшзЖчи│хоЪцАзхТМхЕищЭвщГич╜▓щАЙщб╣чЪДф╝Бф╕Ъф╝ЪхПСчО░ TensorFlow Text цШпф╕Аф╕кхоЙхЕичЪДщАЙцЛйя╝МшАМхп╗ц▒ВхЕ╝хЕ╖х╝║хдзхКЯшГ╜чЪДш╜╗щЗПч║зшзгхЖ│цЦ╣цбИчЪДхЫвщШЯхИЩх║ФшпешАГшЩС FlairуАВ

щЪПчЭА NLP цКАцЬпцМБч╗нф╗ецГКф║║чЪДщАЯх║жхПСх▒Хя╝Мф║Жшзгш┐Щф║Ых║УчЪДхКЯшГ╜хТМхПСх▒Хш╢ЛхК┐х░ЖцЬЙхКйф║ОцВиф╕║щб╣чЫохБЪхЗ║цЬАф╜│щАЙцЛйя╝Мх╣╢ф╜┐цВичЪДх║ФчФичиЛх║ПхзЛч╗ИхдДф║ОщвЖхЕИхЬ░ф╜НуАВ

цВичЪДф╕Лф╕Аф╕к NLP щб╣чЫоцШпф╗Аф╣Ия╝Яш┐Щф║Ых║Уф╕нхУкф╕Аф╕кхПпшГ╜цЬАчмжхРИцВичЪДчЙ╣хоЪщЬАц▒Вя╝Я